其中包含了大量的文字信息、图片的使用量不断增加,随着数字化时代的发展。成为了亟待解决的问题,如何地将这些图片中的文字提取出来。并分析这项技术在实际应用中所面临的挑战,本文将重点探讨以怎样的方式批量识别图片中的文字。

一、图像文字识别技术的发展历程及现状

目前已经取得了显著的突破,图像文字识别技术的起源可以追溯到上世纪90年代,随着深度学习和计算机视觉领域的进展。并分析当前的研究现状、本节将回顾图像文字识别技术的发展历程。

二、基于深度学习的图像文字识别算法分析

深度学习已经成为图像文字识别领域的主要方法之一。并分析其优势和不足之处、本节将详细介绍基于深度学习的图像文字识别算法。

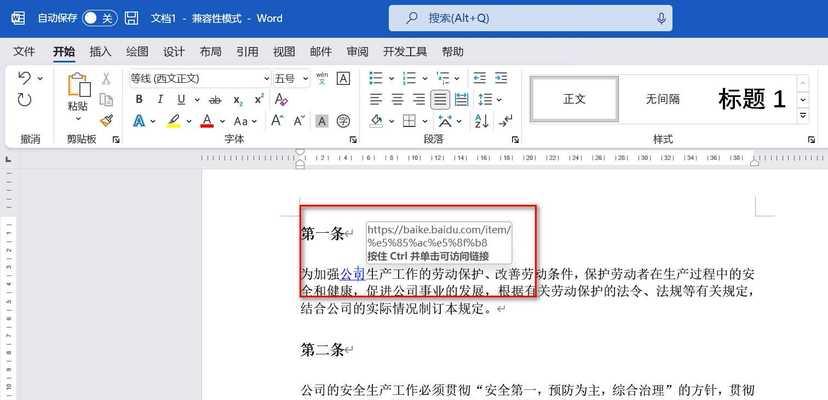

三、批量图像文字识别的数据预处理方法

对图像进行预处理是非常重要的,在进行批量图像文字识别之前。以提高图像文字识别的准确性和效率、图像增强等,本节将介绍一些常用的图像数据预处理方法,如图像去噪。

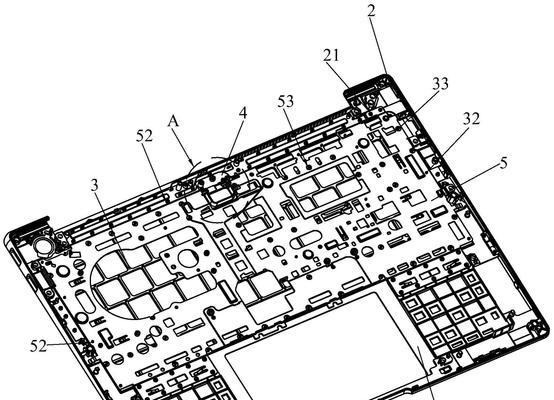

四、基于特征提取的图像文字识别方法

特征提取也是一种常用的图像文字识别方法,除了深度学习之外。并对比其与深度学习方法的优劣势、本节将介绍基于特征提取的图像文字识别方法。

五、图像文字识别中的文本行定位与分割技术

文本行定位与分割是图像文字识别的关键环节。并分析它们在实际应用中的表现、本节将介绍一些常用的文本行定位与分割技术。

六、批量图像文字识别中的并行计算技术

因此并行计算技术成为提高处理效率的关键、由于批量图像文字识别任务通常需要处理大量的图片数据。本节将探讨在批量图像文字识别中如何使用并行计算技术以提高处理速度。

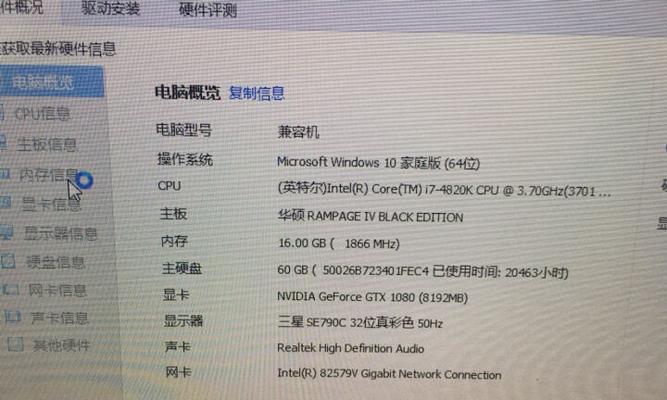

七、图像文字识别技术在实际场景中的应用案例分析

并对其应用前景进行展望、分析图像文字识别技术在金融,本节将以实际案例为例,医疗等领域的应用情况,电子商务。

八、图像文字识别技术的挑战与解决方案

但仍然面临一些挑战,虽然图像文字识别技术取得了许多进展。并提出相应的解决方案,本节将分析图像文字识别技术所面临的挑战。

九、图像文字识别技术的发展趋势与展望

图像文字识别技术也将不断迭代和进化,随着人工智能技术的不断发展。并分析其可能的应用场景,本节将展望未来图像文字识别技术的发展趋势。

十、图像文字识别技术的社会影响与伦理问题

但同时也引发了一些伦理问题,图像文字识别技术的广泛应用将给社会带来巨大的变革。本节将探讨图像文字识别技术对社会的影响以及相关的伦理问题。

十一、图像文字识别技术与其他领域的结合

将为更多的应用场景带来新的可能性,机器翻译等领域的结合、图像文字识别技术与自然语言处理。并分析其潜在应用前景,本节将介绍图像文字识别技术与其他领域的结合。

十二、图像文字识别技术的商业化机会与挑战

但同时也面临着一些挑战、图像文字识别技术的商业化潜力巨大。并提出相应的解决方案,本节将探讨图像文字识别技术的商业化机会与挑战。

十三、图像文字识别技术的竞争格局与市场前景

目前,各家企业纷纷推出自己的解决方案、图像文字识别技术市场竞争激烈。并展望其未来的市场前景、本节将分析图像文字识别技术的竞争格局。

十四、图像文字识别技术的应用价值与未来发展方向

其应用价值不断凸显、图像文字识别技术作为一项核心人工智能技术。并提出未来发展的方向、本节将图像文字识别技术的应用价值。

十五、与展望

挑战和应用前景,介绍了该技术的发展历程、本文围绕大规模图像文字识别技术展开讨论,现状。并具备广阔的发展前景,我们可以看到图像文字识别技术在实际场景中具有重要的应用价值、通过对各个方面的分析。相信图像文字识别技术将在未来实现更加广泛的应用,随着相关技术的不断进步和应用场景的丰富。